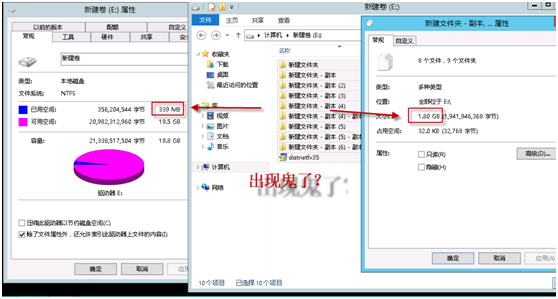

一块磁盘20G,拷贝多个.Net3.5的安装文件到磁盘的不同目录,总共占用1.8G空间。请问使用多少空间,还剩多少空间?如果我告诉你只占用339M,剩余19.5G,你不会认为出现鬼了?

事实上这只是微软WindowsServer2012的一项小功能罢了,在上一篇文章中介绍的SMB管理中,已经对该功能有一定介绍,但是未做具体的测试和验证。今天就跟随我来学习一下吧。

企业中基于文件的数据正在快速增加。磁盘存储成本正在稳定下降,但下降速度却不足以抵消这种增长,这就使得存储效率成为大多数企业 IT 部门的一项关键要求。而且,只要有数据就需要有效率,不管该数据位于数据存储中还是通过 WAN 来移动。 企业中基于文件的数据正在快速增加。磁盘存储成本正在稳定下降,但下降速度却不足以抵消这种增长,这就使得存储效率成为大多数企业 IT 部门的一项关键要求。而且,只要有数据就需要有效率,不管该数据位于数据存储中还是通过 WAN 来移动。 为了应对这种增长,客户正在整合服务器,并将容量扩展和优化作为整合平台的重要目标。Windows Server® 2012 提供本文所述的重复数据删除。 为了应对这种增长,客户正在整合服务器,并将容量扩展和优化作为整合平台的重要目标。Windows Server® 2012 提供本文所述的重复数据删除。 |

如何让1.8G和339M做一个等式,同时保证数据安全,微软可是有说法的。

重复数据删除指的是在数据中查找和删除重复内容,而不会影响其保真度或完整性。目标是通过将文件分割成小的 (32-128 KB) 且可变大小的区块、确定重复的区块,然后保持每个区块一个副本,在更小的空间中存储更多的数据。区块的冗余副本将被单一副本的引用所取代,将区块组织成容器文件,然后将容器压缩进行进一步空间优化。 重复数据删除指的是在数据中查找和删除重复内容,而不会影响其保真度或完整性。目标是通过将文件分割成小的 (32-128 KB) 且可变大小的区块、确定重复的区块,然后保持每个区块一个副本,在更小的空间中存储更多的数据。区块的冗余副本将被单一副本的引用所取代,将区块组织成容器文件,然后将容器压缩进行进一步空间优化。 对某个卷启用重复删除并优化数据之后,该卷包含以下内容: 对某个卷启用重复删除并优化数据之后,该卷包含以下内容: 未优化的文件,即跳过的文件,例如:系统状态文件、加密的文件、具有扩展属性的文件、小于 64KB 的文件以及重分析点文件(之前的已优化文件,包含指向构建该文件所需的区块存储中各个区块的指针) 未优化的文件,即跳过的文件,例如:系统状态文件、加密的文件、具有扩展属性的文件、小于 64KB 的文件以及重分析点文件(之前的已优化文件,包含指向构建该文件所需的区块存储中各个区块的指针) 已优化的文件(存储为重分析点) 已优化的文件(存储为重分析点) 区块存储(已优化的文件数据) 区块存储(已优化的文件数据) 其他可用空间(由于已优化的文件和区块存储占用的空间比优化之前占用的空间少很多) 其他可用空间(由于已优化的文件和区块存储占用的空间比优化之前占用的空间少很多) 结果是对每个文件进行了磁盘转换。重复删除之后,文件不再作为独立的数据流进行存储,而是替换为指向存储在通用区块存储位置的数据块的存根。由于这些文件共享块、这些区块仅存储一次,从而减少了存储这些文件所需的磁盘空间。在文件访问期间,正确的区块会采用透明的方式组装以处理数据,而不需要调用应用程序,也无需用户了解文件磁盘转换中的变化。这样管理员便能够对文件应用重复删除,而无需担心对应用程序或访问这些文件的用户的行为有任何影响或改变。 结果是对每个文件进行了磁盘转换。重复删除之后,文件不再作为独立的数据流进行存储,而是替换为指向存储在通用区块存储位置的数据块的存根。由于这些文件共享块、这些区块仅存储一次,从而减少了存储这些文件所需的磁盘空间。在文件访问期间,正确的区块会采用透明的方式组装以处理数据,而不需要调用应用程序,也无需用户了解文件磁盘转换中的变化。这样管理员便能够对文件应用重复删除,而无需担心对应用程序或访问这些文件的用户的行为有任何影响或改变。 |

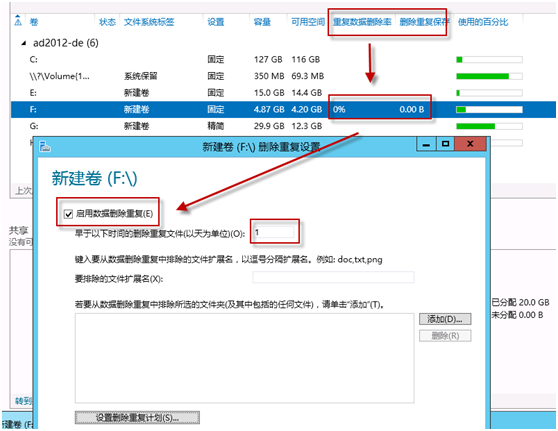

操作非常简单,我们来具体的学习一下。首先打开服务器管理器→和存储服务→卷,看到如下界面。我们在任意一个需要维护的磁盘上右键点击,选择"配置数据删除重复",为了让效果更快体现,我们可以把时间改为0天。

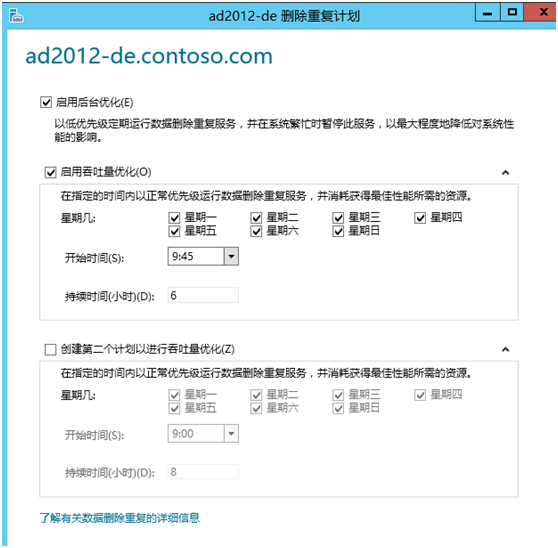

接下来,我们点击"设置删除重复计划",开始时间处,我们输入一个比真实时间快两分钟的时间,这样可以尽快的看到效果。

稍等片刻后,回到"卷",你会发现重复数据删除率和删除重复保存处有所改动。这也正是1.8G和339M相等的根本原因。

需要注意的是,重复删除并不意味着在某些文件夹中就没有目标文件了,而是"看起来"系统结构和操作与以往一样,但在Windows的深层次,系统理解有变化了。

总结:

那么我们把这项功能利用在生产环境有什么意义呢?

比如技术部的共享文件夹中保存了一个暴风影音的安装文件、视频部也保存了一个同版本的暴风影音安装文件,那么磁盘空间就可以因为这个原因节省出来。当然,暴风影音很小,如果保存的是光盘ISO呢?动辄3、4G的文件,每个部门都要自己保存一份,重复率自然就上升了,而启用重复数据删除后,磁盘占用也就可以降低下来了。

原创文章,转载请注明: 转载自奶油九叔

本文链接地址: WindowsServer2012史记4-体验重复数据删除的魅力